近来,美国一家公司生产的超仿真机器人Sophia在电视节目上与人类对答如流,成为“网红”机器人。对话中,Sophia流露出的喜悦、惊奇、厌恶等表情真实得令人赞叹,网友惊呼:快和真人分不清了!

技术往往是一把双刃剑。人工智能在迅速发展的同时,也带来了一些困惑和挑战。人工智能会产生自主意识和情感吗?会不会因此给人类社会带来冲击?

法律争议

假设无人车伤了人,那么是开发者负责还是驾驶公司负责

关于人工智能带来的“伦理困境”,让很多专家感到纠结。尽管这样的场景在目前还只存在于设想中:一辆载满乘客的无人驾驶汽车正在行驶,遭遇一位孕妇横穿马路的突发状况,如果紧急刹车可能会翻车伤及乘客,但不紧急刹车可能会撞到孕妇。这种情况下,无人车会怎么做?

如果司机是人,那个瞬间完全取决于人的清醒判断,甚至是本能或直觉。可当人工智能陷入人类“伦理困境”的极端情景时,其每一步都是通过算法设定好了的。

“无人车依靠的是人工智能大脑,它目前不可能做超出人类算法中所设定范围的行为决策。”浙江大学计算机学院教授吴飞说,将全国每年的交通事故数据“喂”给计算机,人工智能可以学习海量数据里隐含的各种行为模式。简单来说,就是无人车会从以往案例数据库中选取一个与当前情景较相似案例,然后根据所选取案例来实施本次决策。

但遇到完全陌生的情景,计算机会怎么办?“无人车第一个选择仍然是搜索,即在‘大脑’中迅速搜索和当前场景相似度大于一定阈

值的过往场景,形成与之对应的决断。如果计算机搜索出来的场景相似度小于阈值,即找不到相似场景,则算法可约束无人车随机选择一种方式处理。”吴飞说。

“程序员可通过代码来约定无人车如何做,但这种约定始终要遵循普遍的社会伦理。这个过程中,程序员要和伦理学家一同参与把关,程序员要将符合伦理的决策用代码的形式体现出来,输入到系统中。”吴飞认为。

无人车伤害了人类,谁来负责呢?

“当前人工智能尚未达到类人智能或超人智能水平,不能将人工智能作为行为主体对待。”浙江大学教授盛晓明说,从技术角度看,现在技术实现层次还很低,行为体出了问题肯定只能找它的设计者。从哲学角度看,赋予人工智能“主体”地位很荒诞。“主体”概念有一系列限定,譬如具有反思能力、主观判断能力以及情感和价值目标设定等。人工智能不是严格意义上的“智能”。

“人工智能表现出来的智能以及对人类社会道德行为规范的掌握和遵循,是基于大数据学习结果的表现,和人类主观意识有本质的不同。人工智能不是生物,构不成行为主体,传统司法审判无法照搬到人工智能身上。因此,人工智能不可以作为社会责任的承担者。”中国社科院社会学研究所副研究员赵联飞持同样观点。

“以无人车为例,究竟由人工智能开发者负责,还是无人驾驶公司负责甚至任何的第三方负责,或者这几者在何种情形下各自如何分担责任,应当在相关人工智能的法律法规框架下通过制订商业合同进行约定。”赵联飞说。

情感迷思

人与人工智能出现类夫妻、父女等情感,将考问现代伦理规范

科幻影迷一定不会忘记这几个片段:电影《机械姬》的结尾,机器人艾娃产生了自主意识,用刀杀了自己的设计者;在电影《她》中,人类作家西奥多和化名为萨曼莎的人工智能操作系统产生了爱情。只可惜,西奥多发现萨曼莎同时与很多用户产生了爱情,二者所理解的爱情原来根本不是一回事。

尽管科幻电影对人工智能的描述偏向负面,但它也在一定程度上表达了人类的焦虑和担忧。现实中,人工智能会拥有自主意识,和人类会产生情感吗?

“这要取决于如何界定‘产生’一词。人工智能的自主性,仍然取决于所学习的样板和过程。正如阿尔法狗对每一步对弈的选择是从海量可能棋局中选择一种走法一样,这种自主在终极意义上是一种有限的自主,它实际上取决于所学习的那些内容。”在赵联飞看来,人工智能意识和情感的表达,是对人类意识和情感的“习得”,而不会超过这个范围。

机器能不能超出对人类的学习,主动产生意识和情感?吴飞认为,以目前的研究来看,这是遥不可及的。但有一种假设的、可供探讨的路径是,通过把人的大脑认识通透,就可以造一个像人的大脑一样的机器出来。“遗憾的是,我们对人的大脑如何产生意识和情感这些根本问题还了解不够。”

人工智能越来越像人,人类对机器有了感情怎么办?

“人类是否会与人工智能产生感情,将取决于这种过程是否给人类带来愉悦。正如互联网发展早期的一句常用语所说——在互联网上,没人知道你是一条狗。这表明,当人类在不知道沟通者的身份时,只要对方能够给自己带来愉悦,感情就可能产生。”赵联飞认为,这可能会对人类的交往模式带来影响。比如说,未来,知识型的人工智能可以回答人们能够想到的很多问题,从而导致个体学习方式、生活方式乃至社会化模式的变革。

假如人与人工智能出现类夫妻、父女等情感,将考问现代伦理规范。“如果社会主流意见认为这种关系符合伦理,人们可能倾向于以类似于夫妻、父女之间的伦理准则来调节二者之间的关系;但如果人们始终认为,人与人工智能之间的关系是人占主导地位的‘游戏关系’,那么相应的伦理标准也就无从谈起。”赵联飞说。

未雨绸缪

专家建议完善人工智能技术规范和法律约束

面对人工智能带来的种种冲击,专家认为,上世纪50年代美国科幻小说家阿西莫夫提出的机器人三大定律,今天依然有借鉴意义。这三大定律是:机器人不得伤害人,也不得见人受到伤害而袖手旁观;机器人应服从人的一切命令,但不得违反第一定律;机器人应保护自身的安全,但不得违反第一、第二定律。

“归根结底,人是智能行为的总开关。”吴飞认为,人类完全可以做到未雨绸缪,应对人工智能可能带来的威胁。

“开发者应该始终把人工智能对社会负责的要求,放在技术进步的冲动之上。正如生物克隆技术,从提出克隆技术那一天开始,克隆的社会伦理问题就始终优先于克隆的技术问题。”赵联飞认为,人类应该在开发人工智能的过程中,逐步积累控制人工智能的经验和技术,尤其是防止人工智能失控的经验和技术。

在技术上加强对人工智能的控制是完全可行的。“人工智能尽管日益高级,但究其根本,仍然是在智能程序对大量数据处理基础上得到的结果。进行编程时,开发者可以通过程序对其进行安全设置。比如,如果识别出来是人类,要自动保持距离;不能做出攻击性动作,从力学幅度上予以约束。”中科院自动化所研究员孙哲南说,还可以把人类的法律规范和道德要求用代码的形式写入机器,全部数字语言化,使其遵守人类的行为准则。

“除了设计和建造要遵循技术规范,还可由政府有关部门牵头,成立由人工智能技术专家、社会科学研究人员、政府管理人员为核心的人工智能管理委员会,对涉及人工智能的研究和开发项目进行审核评估,严格控制从技术转化为产品的环节。”赵联飞认为,此外,应从多个方面加强对人工智能的研究,跟踪、了解人工智能的发展趋势和实践,开展以未来学为基本范式的研究。

关键词: 人工智能

携手并进,共谋发展,66印与智学网开启深化合作新篇章

近日,66印与智学网签署合同增补协...

携手并进,共谋发展,66印与智学网开启深化合作新篇章

近日,66印与智学网签署合同增补协...

《求真与写真》——国际学者方建文为陕西作家贾平凹发声

《求真与写真》 ——国际学者方建...

《求真与写真》——国际学者方建文为陕西作家贾平凹发声

《求真与写真》 ——国际学者方建...

安徽卫视《去户外吧少年》首播 儿童户外大课堂开课啦

由国大华闻出品、国控星鲨独家冠名...

安徽卫视《去户外吧少年》首播 儿童户外大课堂开课啦

由国大华闻出品、国控星鲨独家冠名...

点亮乡村振兴路,新华社携手希沃跨越粤黔两地共建“千里课堂”

我很喜欢这样的上课方式红色课堂让...

点亮乡村振兴路,新华社携手希沃跨越粤黔两地共建“千里课堂”

我很喜欢这样的上课方式红色课堂让...

博鳌国际青少年服务创新大会社会主义核心价值观创新论坛签约仪式在京召开

为进一步切实践行社会主义核心价值...

博鳌国际青少年服务创新大会社会主义核心价值观创新论坛签约仪式在京召开

为进一步切实践行社会主义核心价值...

自学适用|理科生如何高效自学中传文史哲

中国传媒大学是许多艺考生的梦中情...

自学适用|理科生如何高效自学中传文史哲

中国传媒大学是许多艺考生的梦中情...

美术宝X和平杯——2022中欧青少年先锋艺术作品大赛

大赛介绍Competitionintroduction...

美术宝X和平杯——2022中欧青少年先锋艺术作品大赛

大赛介绍Competitionintroduction...

希沃软件升级发布:数字化教学教研管理工具、平台帮助教师减负增效

聚焦教师成长与发展,希沃数字化技...

希沃软件升级发布:数字化教学教研管理工具、平台帮助教师减负增效

聚焦教师成长与发展,希沃数字化技...

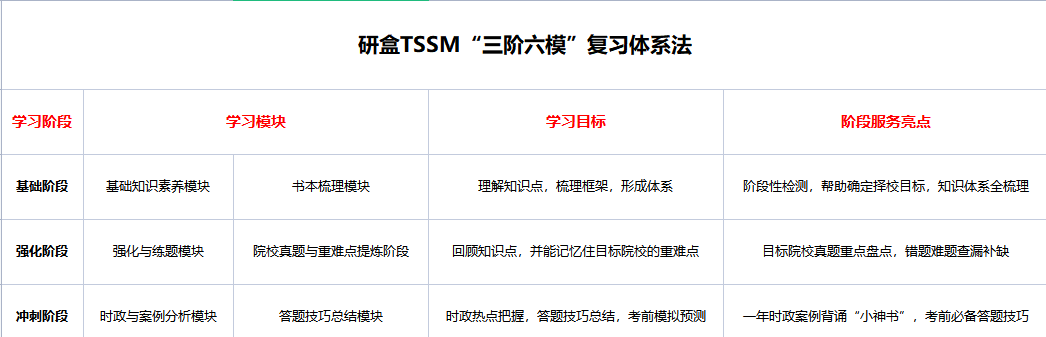

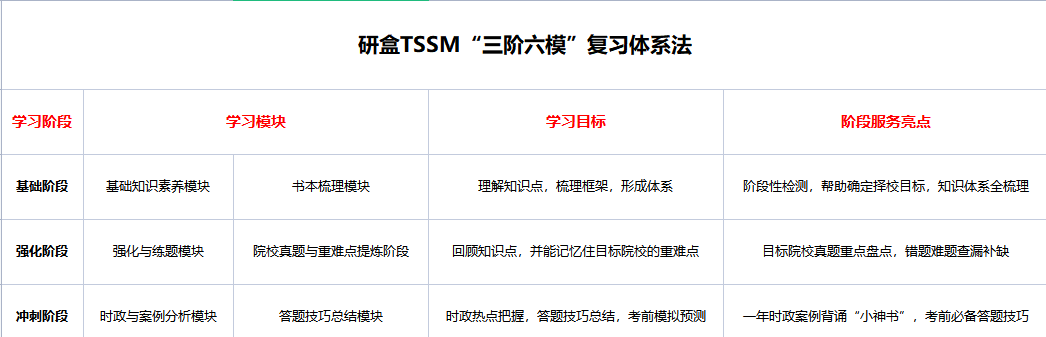

TSSM“三阶六模”复习体系法走红 考研机构要靠真诚、专业、服务到位实现破圈!

据悉,2022年全国硕士研究生报名人...

TSSM“三阶六模”复习体系法走红 考研机构要靠真诚、专业、服务到位实现破圈!

据悉,2022年全国硕士研究生报名人...

领保知识精准送达,平安出行保驾护航

由北京市外办主办的领保速递站活动...

领保知识精准送达,平安出行保驾护航

由北京市外办主办的领保速递站活动...

如何选择广东高考复读学校?来看看肇庆博纳实验学校

孩子一直是班上学习成绩优异的学生...

如何选择广东高考复读学校?来看看肇庆博纳实验学校

孩子一直是班上学习成绩优异的学生...

最懂校服风向 最懂行业趋势 派逊校服抢先占位未来市场

近日,2023新型校服面辅料流行趋势...

最懂校服风向 最懂行业趋势 派逊校服抢先占位未来市场

近日,2023新型校服面辅料流行趋势...

人工智能与大数据加持,上海四区在这个暑假为中小学生打造线上体育运动社区

自2009年起宣布每年8月8日的为全民...

人工智能与大数据加持,上海四区在这个暑假为中小学生打造线上体育运动社区

自2009年起宣布每年8月8日的为全民...

启途教育:做好3点轻松帮你通过初级会计

初级会计证书可以说是财会人进入行...

启途教育:做好3点轻松帮你通过初级会计

初级会计证书可以说是财会人进入行...

“下一站,顺丰”,拉响品牌年轻化战役

作为首批进入大学的00后,当代大学...

“下一站,顺丰”,拉响品牌年轻化战役

作为首批进入大学的00后,当代大学...

希沃软件升级发布:数字化教学教研管理工具、平台帮助教师减负增效

聚焦教师成长与发展,希沃数字化技...

希沃软件升级发布:数字化教学教研管理工具、平台帮助教师减负增效

聚焦教师成长与发展,希沃数字化技...

TSSM“三阶六模”复习体系法走红 考研机构要靠真诚、专业、服务到位实现破圈!

据悉,2022年全国硕士研究生报名人...

TSSM“三阶六模”复习体系法走红 考研机构要靠真诚、专业、服务到位实现破圈!

据悉,2022年全国硕士研究生报名人...

领保知识精准送达,平安出行保驾护航

由北京市外办主办的领保速递站活动...

领保知识精准送达,平安出行保驾护航

由北京市外办主办的领保速递站活动...

如何选择广东高考复读学校?来看看肇庆博纳实验学校

孩子一直是班上学习成绩优异的学生...

如何选择广东高考复读学校?来看看肇庆博纳实验学校

孩子一直是班上学习成绩优异的学生...